Insbesondere wenn viele Autoren an einem Blog oder Magazin arbeiten und die Keyword-Recherche nicht zentral oder transparent gesteuert wird, kann es passieren, dass verschiedene Artikel zu denselben Themen erstellt werden. Irgendwann klopft dann vielleicht ein SEO an die Tür und verlangt nach einer Konsolidierung. Wieso? Was hat er oder sie gesehen und ist die Konsolidierung die richtige Reaktion? Die Antwort ist klar: Ja! Und nein! Aber zuerst:

Was ist eine Content-Konsolidierung?

Lange Rede, kurzer Sinn: Konsolidieren meint zusammenfassen. Content, der dasselbe Thema bearbeitet und (versehentlich) auf dieselben Keywords ausgerichtet wurde, sollte zusammengefasst werden. Das klingt erstmal logisch aber warum braucht es dazu einen SEO?

Weil ein SEO die Rankings einer Website regelmäßig kontrolliert. Dabei helfen ihr oder ihm Tools wie Sistrix, Ahrefs, SEMrush oder die Google Search Console. Das erste Warnzeichen ist meistens, wenn mehrere Seiten zu den gleichen Keywords ranken. Man spricht hier auch gern von Keyword-Kannibalismus.

Keyword-Kannibalismus Der Umstand wenn zwei oder mehrere Seiten sich beim Ranking um ein Keyword im Wege stehen. Oftmals durch eine zu ähnliche, thematische Ausrichtung bzw. zu wenig Trennschärfe.

Aber ist das nun schlecht? Ist es denn nicht sogar von Vorteil, wenn meine Seite mehrfach vertreten ist? Die Antwort ist klar: Ja! Und nein.

Achtung! In den folgenden Szenarien werden die Konsolidierungsfälle auf Basis des Rankings, also der Position in den Suchergebnissen beschrieben! Es ist aber wichtig immer Klicks und Impressionen mit einzubeziehen, da man sonst Gefahr läuft, sich mit irrelevanten Inhalten zu beschäftigen, denen keine Nachfrage gegenübersteht. Ein Ranking auf Position 1,2 oder 3 ist nur dann schön, wenn es auch qualifizierten Traffic verspricht!

Szenario #1: Ein Keyword, zwei Seiten, auf den Positionen 1 und 2.

Herzlichen Glückwunsch. Hier gibt es nichts zu tun. Insofern beide Inhalte aktuell sind und keine veralteten Informationen zu deinem Service oder Produkt beinhalten und auch sonst keine Bedenken aus Conversion-Perspektive bestehen, ist hier keine Aktivität gefordert, außer vielleicht stolz zu sein. Die Top Spots mit dem eigenen Inhalten gleich mehrfach zu belegen, ist super! Und selten.

Szenario #2: Ein Keyword, zwei Seiten, auf den Positionen 2 und 15.

Beziehungsweise ein Ergebnis im Top-Spot (Position 1 - 3 ) und eines nicht mal in Reichweite davon. Hier muss im Einzelfall geprüft werden, ob die Mühe lohnt. Wenn das schlechtere Ergebnis nur gelegentlich rankt und daher auch nur wenige Impressionen sammelt, ist es vermutlich nicht die Mühe wert. Hat das schlechtere Ergebnis auch sonst keine nennenswerte Performance (Traffic, Backlinks), kann es im Grunde auch entfernt werden. Eine Zusammenfassung der beiden Seiten ist nur dann zu empfehlen, wenn Seite A mit dem Inhalt von Seite B sinnvoll ergänzt werden kann. Andernfalls ist löschen und umleiten der schlechteren Seite auf die bessere die empfohlene Vorgehensweise.

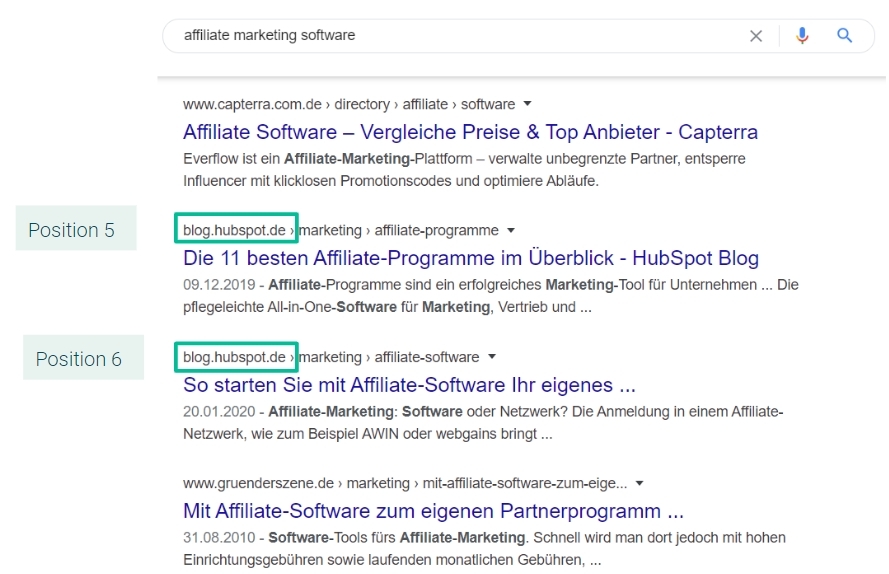

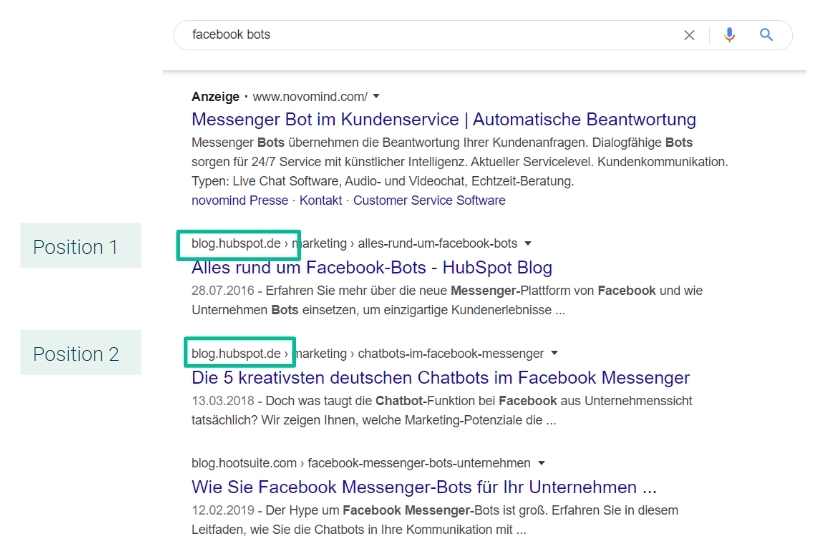

Szenario #3: Ein Keyword, zwei Seiten, auf den Positionen 4 und 5.

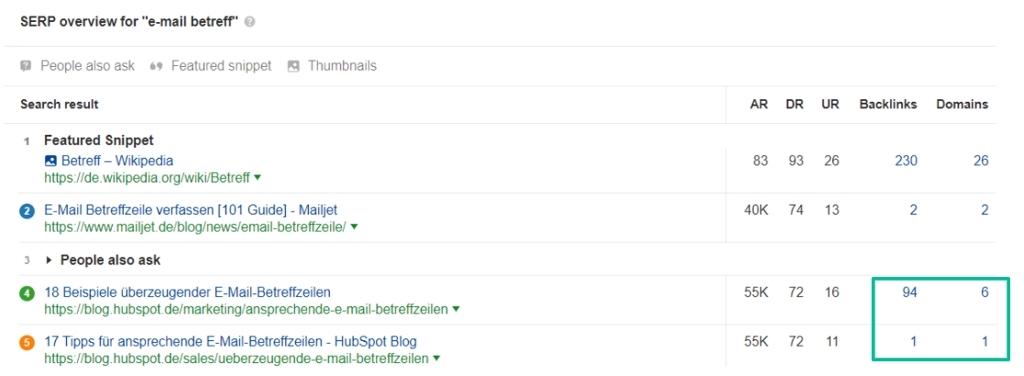

Hier wird es schon interessanter. Die Platzierungen 4 und 5 sind ja nicht schlecht, aber eben auch nicht richtig gut. Wir wissen aus Klickstudien, dass die ersten 3 Ergebnisse im Durchschnitt die meisten Klicks bekommen. Könnte es also sein, dass sich die beiden Seiten gegenseitig daran hindern, im Rankings zu klettern? Hier hilft ein Blick in ein SEO-Tool, das uns mehr Daten liefert als nur Klicks, Impressionen und Position. Werfen wir einen Blick auf Links!

Wir sehen, dass die beiden Seiten im Beispiel eine ähnliche Anzahl an internen und externen Links erhalten. Würde man diese Links nun auf einen statt zwei Inhalten konzentrieren, stehen die Chancen gut, dass man es in die Top-Positionen schafft! Denn eine Seite mit vielen guten Signalen ist besser als zwei Seiten mit nur einer handvoll guter Signale.

Szenario #4: Ein Keyword, zwei Seiten, auf den Positionen 14 und 25.

Auch hier sollte erst einmal geprüft werden, ob beide Seite konstant auf diesen Positionen zu finden sind oder ob es sich um “Gelegenheitsrankings” handelt. Kann dies verneint werden, eignet sich das Vorgehen aus Szenario #3. Andernfalls sollte geprüft werden, ob das jeweilige Keyword von strategischer Bedeutung ist. Da Impressionen und Klicks aufgrund der schlechten Positionen verhältnismäßig wenig ausfallen werden, lohnt sich ein Abgleich der Suchvolumens des Keywords.

Suchvolumen Die durchschnittliche Anzahl monatlicher Suchen zu einem Keywords auf Basis der vergangenen 12 Monate.

Ist das Suchvolumen ausreichend hoch (je nach Business können hier unterschiedliche Maßstäbe gelten), lohnt es sich, Optimierungsmaßnahmen einzuleiten. Da sich in diesem Beispiel allerdings keine der Seiten für die erste Suchergebnisseite qualifiziert hat, ist es mit Konsolidierung allein nicht getan. Hier muss der gesamte Content überarbeitet werden. Im Zuge dessen, kann die konkurrierende Seite direkt konsolidiert werden. In erster Linie wird aber ein sinnvolle Erweiterung des Inhaltes notwendig, sowie Linkaufbau (intern als auch extern) notwendig.

Kannibalismus & Duplikate

Wenn mehrere Seiten nun das gleiche Thema behandeln, spricht man dann bereits von Duplicate Content? Nein. Duplicate Content meint in erster Linie, dass derselbe Inhalte unter unterschiedlichen Adressen abrufbar ist. Das kann deutlich schneller passieren, als einem lieb ist und hat oft technische und keine redaktionellen Gründe.

Google & Duplicate Content

Google ist nicht daran interessiert, den selben Content mehrfach zu speichern. Einzigartigkeit ist hier das Schlüsselwort. Da Duplicate Content dennoch sehr häufig auftaucht, hat Google seine eigenen Strategien entwickelt, damit umzugehen.

Strategie #1: Ignorieren

Wenn Google mehrere Varianten erkennt, aber aufgrund von internen und externen Links einfach erkennen kann, welche Variante die relevante ist, werden die anderen Duplikate einfach ignoriert. Dies ist der einfachste Fall, da sich hier keine Schwankungen in den Rankings zeigen.

Strategie #2: Abwechseln

Wenn Google nicht ausmachen kann, welche Variante die bessere ist, wird es die verschiedenen Varianten wechselseitig als Ergebnis anbieten. Da jede Variante andere Signale (wie interne und externe Links) mit sich bringt, fangen Rankings an zu fluktuieren, also hin und her zu springen. Hier haben wir es mit einem Konsolidierungsfall zu tun, der behandelt werden muss. Wie genau das geht, werden wir noch erläutern.

Strategie #3: Bestrafen

Dies passiert nur, wenn Google feststellt, dass die Inhalte von anderen Websites kopiert wurden bzw. eine Urheberrechtsverletzung besteht. Hier spricht man dann von externem Duplicate Content. Google vermutet hier einen Betrugsversuch und kann die betroffene Domain entsprechend abstrafen. Je nach Umfang kann diese “Strafe” die gesamt Website betreffen. Wichtig ist jedoch, dass nicht jeder Content, der auch auf einer anderen Domain gefunden werden kann, zu einer Strafe führt. Der Klassiker sind Online-Shops, die Produktbestände anderer Anbieter einbinden. Werden Fremdprodukte über den eigenen Shop angeboten, geschieht das oft über einen sogenannten Feed. Die Produktbeschreibungen sind oftmals vorgegeben und werden selten individualisiert. Google weiß um diese gängige Praxis im E-commerce und schleudert hier nicht direkt mit Strafen um sich, sondern reagiert mit Strategie #1: Ignorieren. Allerdings zu Ungunsten derjenigen, welche die Duplikate im eigenen Shop anbieten.

Konsolidieren technischer Duplikate

Der Vorteil an technischen Content-Duplikaten ist, dass man sie durch akkurate Website-Einstellungen bereits im Keim ersticken kann. Dennoch kommen sie mehr als häufig vor: und zwar immer wenn mehrere Versionen einer URL existieren.

Häufig handelt es sich dabei um parametrisierte URLs, also URLs mit einem hinten angehängten Parameter. Das können facettierte Filter, URLs mit Tracking-Parametern (z.B. UTM) oder Session IDs sein.

Wir gehen hier beispielhaft auf die facettierten Filter ein, da dieses Problem häufig in Online-Shops vorkommt.

Facettierte Filter

Facettierte Filter treten vor allem im E-Commerce auf, wenn Nutzer ein bestimmtes Produkt filtern, z.B. bei Schuhgröße, Geschlecht, Farbe, Marke, Stil, Material und Preis. Je nach Webshop wird diese Veränderung in der URL abgebildet, die dann schon mal sehr lang werden kann, wenn ausgewählte Filter aufeinander addiert werden:

Beispiel: domain.de/sneaker/?filters_color=Gelb&filters_.gender=female&filters_style=Sportlich&filters_price_from=50&filters_price_to=100&filters_size=Eu39

Hier kann es zu Kombinationsmöglichkeiten im Millionenbereich kommen. Dieser Umstand bringt weit mehr Probleme mit sich als nur Duplicate Content. Aber das steht auf einem anderen Blatt. Das Problem ist hier, dass trotz der veränderten Produktauswahl, der Main Content oftmals der gleiche bleibt. Es entstehen also unter Umständen Millionen von Seiten mit dem selben Kerninhalt, ergo Duplicate Content. Für Nutzer des Shops ist es aber ein wichtiges Feature, denn man möchte ja Produkte gemäß den eigenen Anforderungen filtern können! Technisch sollte das Ganze durch einen sauberen Einsatz von Ajax oder anderen JavaScript-Technologien realisiert werden. Der Einsatz solcher Technologien verhindert, dass Google sich im Wirrwarr unendlicher Filterkombinationen verläuft.

Gleicher Inhalt, andere URL

Über parametrisierte URLs hinaus gibt es auch noch andere Wege, verschiedene Varianten ein und derselben URL zu erzeugen. Wir stellen die wichtigsten vor:

- HTTP vs. HTTPS: http://www.domain.de vs. https://www.domain.de. Hier sollte immer das sichere, verschlüsselte HTTPS verwendet werden

- www- und nicht-www-Varianten: https://www.domain.de vs. https://domain.de

- URLs mit und ohne Trailing Slash (das ist der Slash am Ende einer URL, der meistens optional zu setzen ist) - tatsächlich werden die URLs domain.de/page und domain.de/page/ technisch als zwei verschiedene Seiten angesehen

- kurze, lesefreundliche URL-Varianten einer längeren URL, z.B. domain.de/home/index.html vs. domain.de/home/

- Mehrfachzuordnung von Kategorien - wenn eine Seite in mehreren Kategorien liegt und die Kategorien in den URLs abgebildet werden, z.B. domain.de/oberteile/tanktop vs. domain.de/t-shirts/tanktop

Die meisten dieser Duplikate kann man vermeiden, indem man Redirect-Regeln einrichtet, die Seiten zu der festgelegten Standard-Variante per 301 oder 302 Status Code umleiten.

Doch nicht immer ist ein Redirect von Seite A auf Seite B ein gangbarer Weg. Zum Beispiel beim Einsatz von Tracking-Parametern. Der Klassiker unter den Tracking-Parametern ist UTM.

UTM-Parameter UTM steht für Urchin Tracking Module und stammt vom Google Analytics Vorgänger Urchin. Mit Hilfe dieser Parameter lassen sich zusätzliche Informationen transportieren, wie Kampagne (utm_campaign), Medium (utm_medium), Quelle (utm_source) und Keyword (utm_term). Sie dienen dazu, im eigenen Web Analytics genau erkennen zu können, über welche Kampagne der Traffic auf die jeweilige Zielseite gelangt ist.

Solche “Kampagnen”-Parameter sollte man nicht auf die Orignal-URLs (also ohne Parameter) weiterleiten, da sonst wichtige Informationen für die Kampagnen-Analyse verloren gehen. Das richtige Instrument ist hier das “Canonical”- Tag.

Canonical Der Canonical ist ein HTML Code im

einer Seite, der Suchmaschinen darauf hinweist, wo die Original-URL zu finden ist. Suchmaschinen “verschieben” dann (meistens) alle Ranking-Signale auf diese kanonische URL. Canonicals können immer dann eingesetzt werden, wenn Redirects nicht die korrekte Maßnahme sind. Wichtig ist jedoch, dass Canonicals keine Imperative sind; es sind Empfehlungen an die Suchmaschine. Google behält sich vor, ob es dieser Empfehlung folgt oder eben nicht. Den passenden Bericht dazu findet man in der Google Search Console.

Ein weiteres Beispiel ist lokal ausgerichteter Content in derselben Sprache, zum Beispiel verschiedene Versionen einer Seite für US, UK und Kanada, auf denen sich womöglich nur die Währung unterscheidet. Hier sollte man darauf achten, dass die Seiten Hreflang-Annotationen nutzen, die auch zu 100% valide sind, also den Regeln entsprechen. Ansonsten kann es passieren, dass sie nicht ausgelesen werden können und die Inhalte als Duplikate gewertet werden.

hreflang Der hrelang Tag ist ein HTML Code im

<head>einer Seite, der Suchmaschinen darauf hinweist, dass eine individuelle Seite auch in anderen Sprachen bzw. für andere Regionen existiert. Diesen Hinweis nutzt Google entsprechend für die lokalen Versionen seiner Domains wie google.com, google.de, google.at usw.

Auch Entwicklungsumgebungen, die dafür da sind, technische Entwicklungen zunächst zu testen, bevor man sie auf der “richtigen” Seite installiert, können zu Duplikaten führen. Hier empfiehlt es sich, diese Seiten durch HTTP-Authentifizierung zu schützen, also ein Passwort zu vergeben oder die gesamte Domain der Entwicklungsumgebung via robots.txt zu sperren. So kann Google die Seiten auch nicht indexieren. Sollte eine Indexierung bereits erfolgt sein, kann man dies mithilfe des “noindex” Tags in den Meta Robots wieder rückgängig machen.

Wie konsolidiert man thematisch ähnliche Inhalte?

Im besten Fall entstehen keine inhaltlichen Überschneidungen auf einer Website, doch die Realität sieht oft ganz anders aus: Eine fehlende Content-Strategie und fehlende (regelmäßige) Content Audits führen bei regelmäßiger Content-Publikation zwangsläufig dazu, dass die Seite gewissermaßen ausfranst.

Zunächst einmal muss man Seiten mit gleichem oder sehr ähnlichem Inhalt identifizieren und das gestaltet sich mitunter ziemlich schwierig. Hat eine Domain mehrere Tausend oder sogar Millionen Seiten, kann man sich natürlich nicht jede Seite einzeln ansehen. Bei kleineren Seiten, die eventuell sogar eine thematische Kategorisierung aufweisen, kann man hingegen heuristisch vorgehen. Generell empfiehlt es sich, Stück für Stück zu arbeiten und gleich mehrere Konsolidierungsrunden einzuplanen - hier zählt der sorgfältige Prozess mehr als das schnelle Ergebnis.

Wir haben sechs Schritte zum Thema Content-Konsolidierung zusammengestellt.

Schritt 1: Konsolidierungskandidaten identifizieren

Man beginnt am besten mit den offensichtlichsten Fällen, nämlich mit denjenigen Seiten, die zu exakt gleichen Keywords ranken. Welche das sind, kann man durch die Rankings der Google Search Console oder anderer Tools wie Ahrefs oder Sistrix leicht herausfinden.

Keywords, die den eigenen Markennamen beinhalten, kann man übrigens direkt ausschließen. Dass mehrere Seiten zur eigenen Marke ranken, lässt sich nicht verhindern und ist bei Licht betrachtet sogar wünschenswert. So oder so sollte man sicherstellen, dass man nur indexierbare URLs mit einbezieht. Klingt logisch, der Hintergrund ist jedoch, dass Google Seiten regelmäßig aus dem Index nimmt, die nicht erreichbar sind. Die Search Console-Daten können je nach gewähltem Zeitraum aber auch historische Daten zu Klicks und Impressionen enthalten.

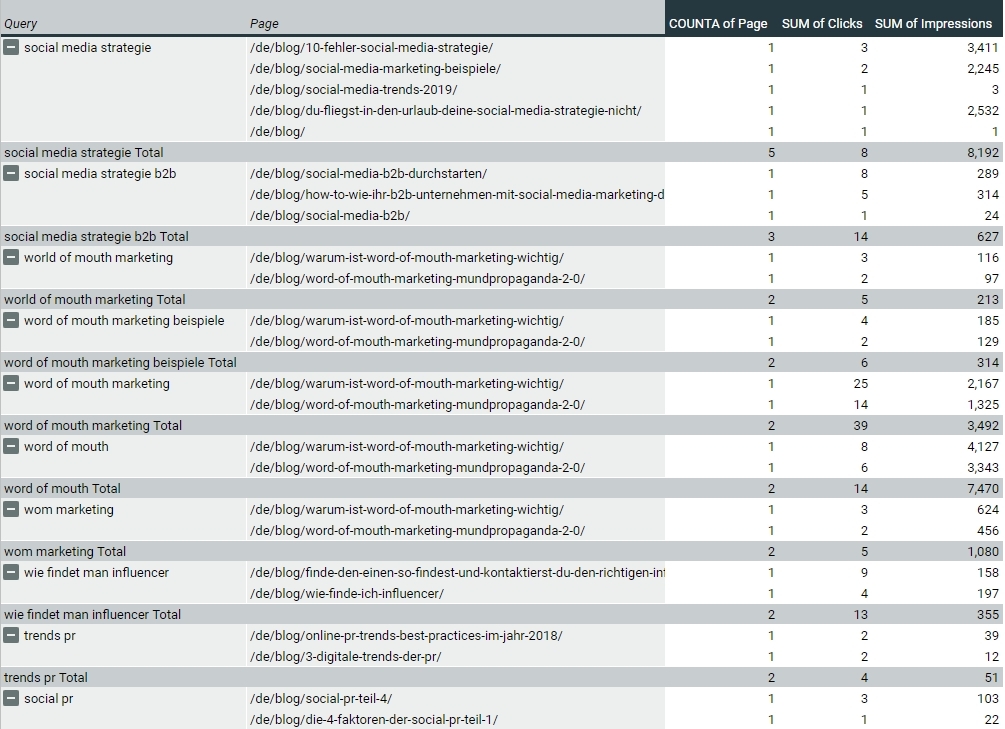

Es wird deshalb empfohlen, die Seiten, die die Search Console ausgibt, zusätzlich mit einem Tool wie dem Screaming Frog zu crawlen und nur kanonische Seiten mit einem 200 Status Code - also indexierbare Seiten - in die Analyse einzubeziehen. Hat man dann eine bereinigte Liste, kann man auf Basis der Keywords eine Pivot-Tabelle erstellen, in der man sich ausgeben lässt, welche und wie viele URLs zu den einzelnen Keywords ranken. Diese Liste sortiert man absteigend nach Anzahl der URLs und kann sich auch die Klicks oder Impressionen dazu anzeigen lassen, um ein umfassendes Bild zu erhalten.

Das könnte ungefähr so aussehen:

Man sieht hier sehr schön, dass mehrere URLs zur selben “Query” (=Keyword) ranken und um Klicks und Impressionen konkurrieren. Ideal wäre es am Ende, wenn die Inhalte, Klicks und Impressionen zu einem Suchbegriff in einer URL gebündelt werden. Damit gibt es dann nur eine Anlaufstelle für Nutzer, eine etablierte Wissensressource, um die herum sich weiterer Content gezielt aufbauen lässt.

Immer zu konsolidieren sind zum Beispiel zurückliegende Jahreszahlen in URLs, den verbundenen Content sollte man entweder aktualisieren oder neutralisieren, indem man die Jahreszahl rausnimmt. Damit verbunden müssen auch alle internen Links auf die integrierten Seiten ausgetauscht und ggf. Weiterleitungen eingerichtet werden, vor allem wenn es viele Backlinks auf die betreffende Seite gibt.

Schritt 2: URLs priorisieren

Wenn wir zwei Seiten konsolidieren möchten, müssen wir zunächst entscheiden, welche der beiden Seiten bestehen bleiben soll und welche entfernt wird. Wir könnten uns zum Beispiel für die URL entscheiden, die inhaltlich besser passt oder zeitloser ist. Wenn ein Artikel mit enger gefasstem Thema in einen weiter gefächerten Artikel eingearbeitet werden soll, dann ist es logischer, letztere URL zu verwenden. Passen thematisch beide URLs, sollte man auf die bisherige Performance schauen und die URL behalten, die mehr Klicks und Impressionen generiert hat. Auch auf die Backlinks sollte man ein Auge haben und möglichst keine URLs entfernen, die Backlinks bekommen.

In dem Beispiel oben schneidet /de/blog/word-of-mouth-marketing-mundpropaganda-2-0/ immer schlechter ab als /de/blog/warum-ist-word-of-mouth-marketing-wichtig/, weshalb es vermutlich klüger wäre, letztere zu behalten und erstere zu integrieren. Dadurch, dass diese zwei Seiten gleich zu mehreren Keywords gleichzeitig ranken, ist dies auch ein eindeutiger Fall von Keywordkannibalismus. Man sollte aber bei der Entscheidung trotzdem auch immer auch auf die Gesamt-Performance achten und nicht nur auf die Performance zu einzelnen Keywords. Es könnte nämlich sein, dass eine bestimmte Seite zu einem spezifischen Keyword mehr Impressionen hat als die andere, dass die andere jedoch insgesamt deutlich besser performt. In dem Fall sollte man genauer hinschauen.

Schritt 3: Inhalte zusammenführen & optimieren

Unsere Kollegin Laura hat diesen Arbeitsschritt in ihren unnachahmlichen Worten auf den Punkt gebracht: “Wenn man schon einmal einen Inhalt qualitativ bearbeitet, dann kann man es auch gleich richtig machen.” Was Laura damit meint, ist: Es gibt keine besseren Argumente, als einen guten Text. Er sollte klar strukturiert und gut zu lesen sein, natürliche Übergänge sowie Bilder oder Grafiken enthalten. Oft ergibt sich im Rahmen einer Konsolidierung die Chance, sich ein Thema nochmals von A bis Z zu vergegenwärtigen und in wertvollen Content zu übersetzen. Relevante Inhalte aus den konsolidierten Seiten können wir präzise in die Zielseite einarbeiten und auch gleich Keywords mit hohem Suchvolumen integrieren, die bisher noch nicht enthalten sind. Auch sollten wir stets überprüfen, ob Title, H1, Image Alt Tags und Meta Description die wichtigsten Keywords enthalten - damit die wichtigsten Weichen direkt auf SEO gestellt sind.

Schritt 4: Aufräumen

Das klingt banal, macht aber meist den größten Zeitaufwand aus, da es sich um eine ziemliche Fleißarbeit handelt. Interne Links müssen angepasst, Canonicals gesetzt oder integrierte URLs auf Ziel-URLs weitergeleitet werden (WordPress: integrierte Seiten auf Entwurf setzen, wenn sie weitergeleitet werden). Es empfiehlt sich, die Ziel-URLs nach der Konsolidierung mithilfe der Search Console an Google zu senden, damit die Änderungen schnellstmöglich vom Crawler abgeholt werden. Wenn der Publikationszeitpunkt als Metadatum vorhanden ist, sollte auch dieser aktualisiert werden, um die Aktualität des Artikels zu unterstreichen.

Schritt 5: Performance Follow-Up

Um sicherzustellen, dass alles geklappt hat und man keine wichtigen Traffic-Quellen verloren hat, sollten wir in den kommenden Wochen den organischen Traffic monitoren und im Notfall einzelne Seiten wiederherstellen. Zu beachten ist jedoch, dass sich Erfolge im SEO-Bereich häufig erst nach längerer Zeit einstellen - es ist also Geduld angesagt. :)

Schritt 6: Schritt 1-5 nach einiger Zeit wiederholen

Zusatz-Tipps

Wir können das Pferd auch von hinten aufzäumen und uns zuerst sehr schlecht performende Inhalte vornehmen oder sogenannten “Thin Content” ins Blickfeld nehmen, also dürftige Inhalte ohne echten Mehrwert. Die Vorgehensweise ist hier entweder komplett manuell oder man nutzt den “site”-Suchoperator auf Google, in dem man den Befehl “site:domain.de keyword” eingibt. Damit kann man z.B. schauen, ob man zu den wichtigsten Schlagworten eines schlecht funktionierenden Artikels noch weitere Seiten innerhalb der Domain findet. Eventuell finden sich darunter auch redundante Artikel, die in der ersten Konsolidierungsrunde noch nicht aufgefallen sind.

Und ansonsten gilt es, keine Scheu davor zu haben, Inhalte auch einfach mal zu löschen. Denn bringen Inhalte gar keinen Traffic, dann sind sie entweder richtig schlecht oder nicht relevant für den Nutzer. Das bloße Eliminieren hat häufig einen positiven Effekt für SEO, da Google weniger irrelevante Seiten crawlen muss und dies als positives Signal deutet. Auch werden die wirklich relevanten Seiten dadurch besser gestellt, da die Gesamtanzahl von Seiten innerhalb der Domain schrumpft und der anteilige Link Juice (siehe unten) der verlinkten Seiten steigt.

Ein Beispiel: Im Discounter finde ich auch schneller, wonach ich suche als in einem großen Supermarkt, wo ich mit vielen für mich irrelevanten Produkten konfrontiert werde, nach denen ich im Grunde nie gesucht habe und daher sogar schwieriger das finde, wonach ich eigentlich suche. Im Online-Marketing nennt man das Link Juice:

Link Juice

Das Reputations-Potential, dass eine Seite auf eine andere vererben kann. Links, intern oder extern, können als Empfehlung für eine Seite verstanden werden. Erhält eine Seite viele Links, scheint sie besonders wichtig zu sein. Verlinkt diese Seite andere Seiten, wird ein Teil dieser Reputation an jene Seiten weitergeleitet. Je mehr Seiten verlinkt werden, desto weniger Link Juice pro verlinkter Seite bleibt übrig.

Habe ich nur wenige Produktregale vor mir, so bekommt das einzelne Produkt mehr Aufmerksamkeit und Interesse. Die Domain bekommt folglich zwar nicht mehr Backlinks, weil wir einzelne Seiten löschen, aber die Backlinks, die schon da sind, verteilen ihren Link Juice auf weniger Seiten, was bedeutet, dass auf jeder Seite (je nachdem wie stark sie angelinkt wird) mehr von dem Link Juice ankommt als vorher - der Grad an gegenseitiger Verknüpfung und Vertrauen. Insofern kann eine Konsolidierung durch ein gezieltes Ausdünnen sehr sinnvoll sein und den vielleicht vorher etwas versteckt gewesenen, qualitativen Content ins Zentrum der Aufmerksamkeit rücken.

Fazit

Die Content-Konsolidierung lohnt sich. Gerade für Redaktionsteams kann der Cleanup im eigenen Repertoire befreiend sein. Denn nichts ist schlimmer, als wenn man keinen Überblick seines eigenen Content hat. Suchmaschinen mögen ohnehin aufgeräumte, klar strukturierte Seiten mit sinnvollem und aktuellen Content. Daher ist die Content-Konsolidierung das Mittel der Wahl, um eine Website inhaltlich zu modernisieren.

SEO

SEO SEA

SEA CRO

CRO Design

Design DEV

DEV