Interne Verlinkungen gehören zu den am meisten unterschätzten Hebeln, um die Sichtbarkeit einer Website aufzubauen. In einem unserer Projekte ging es darum, Content-Seiten zu identifizieren, auf denen eines von vier Kernprodukten zwar erwähnt wurde – aber ohne direkte Verlinkung zur passenden Produktseite.

Das Ziel: Für jedes Produkt eine Liste relevanter URLs zusammenstellen, die wir gezielt intern verlinken konnten. Die Umsetzung lief in zwei Schritten – mithilfe von Screaming Frog und XPath:

- Schritt 1: Seiten finden, die thematisch zu unseren Kernprodukten passen

- Schritt 2: Prüfen, welche dieser Seiten keinen Link zur Produktseite enthalten → via XPath Custom Extraction in Screaming Frog

Schritt 1: Seiten mit inhaltlichem Bezug zu den Kernprodukten finden

Im ersten Schritt haben wir den gesamten Content-Hub gecrawlt und anschließend alle Seiten herausgefiltert, die inhaltlich auf eines unserer vier Kernprodukte Bezug nehmen. Dafür haben wir gezielt folgende Felder überprüft:

- URL-Slug

- Meta Title

- Meta Description

- H1

Im Screaming Frog lassen sich diese Felder bequem über die Filterleiste durchsuchen. Alternativ kannst du auch Tools wie Ahrefs nutzen (Site Audit → Page Explorer), um gezielt Seiten mit Produktnennungen in genau diesen Bereichen zu finden. Das Ergebnis ist eine Liste mit URLs, die eine Produkterwähnung haben.

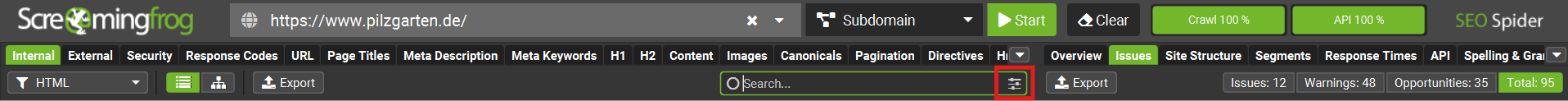

Filterfunktion im Screaming Frog in der Suchleiste wählen.

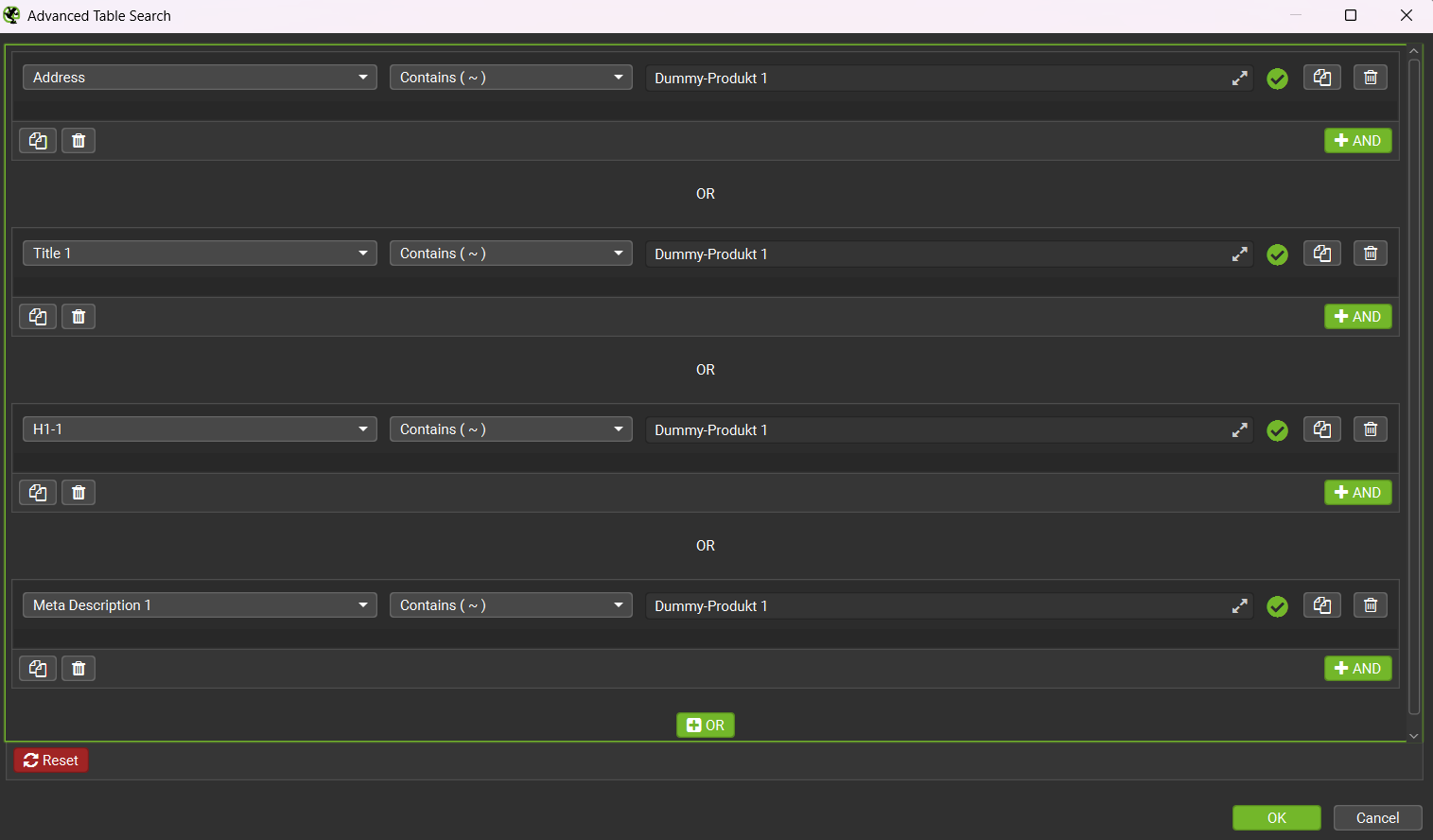

Filtereinstellungen für gesuchte Erwähnungen des Kernprodukts.

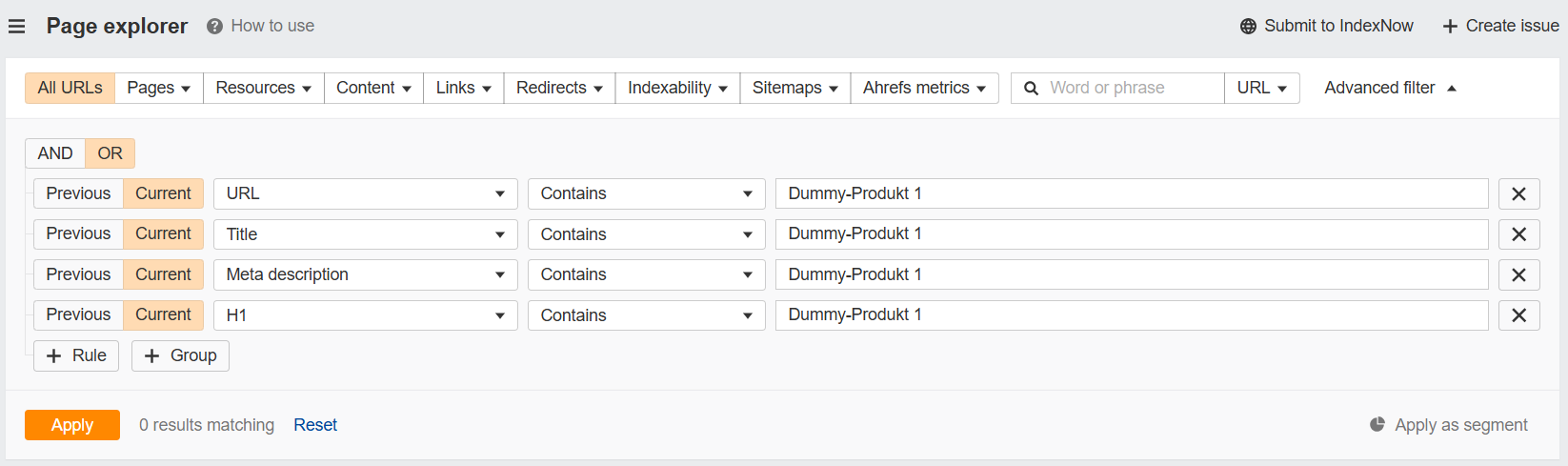

Ahrefs Page Explorer Filterfunktion

Schritt 2: Fehlen interne Verlinkungen? XPath to the rescue!

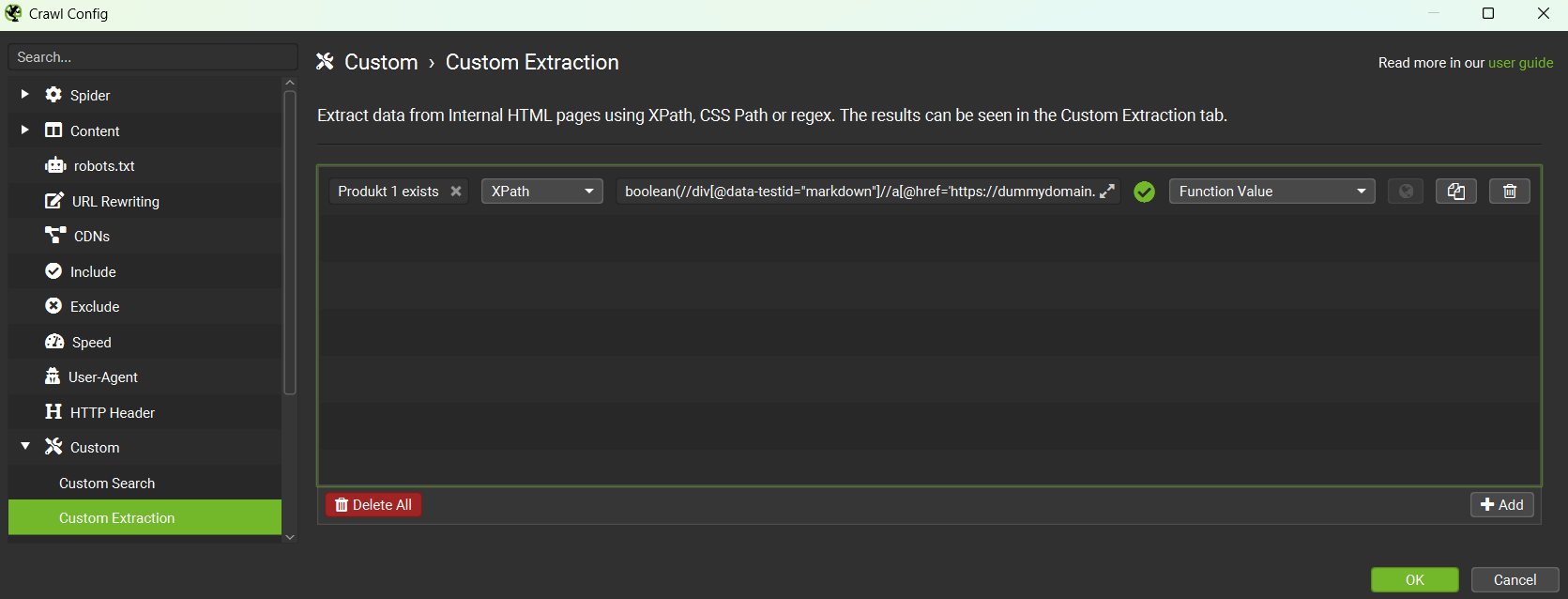

Im zweiten Schritt ging es darum herauszufinden, welche der zuvor identifizierten Seiten keine Verlinkung zur jeweiligen Produktseite enthalten. Dafür haben wir im Screaming Frog SEO Spider die Funktion Custom Extraction genutzt.

Was ist eine Custom Extraction?

Mit der Custom Extraction (unter Configuration > Custom > Custom Extraction) kannst du gezielt Informationen aus dem HTML einer Seite auslesen – etwa Links, Texte oder Attribute. Dabei stehen dir drei Methoden zur Verfügung:

- XPath (ideal für HTML-Strukturen)

- CSSPath

- Reguläre Ausdrücke (Regex)

Du kannst entweder das roh ausgelieferte HTML oder – bei aktiviertem JavaScript-Rendering – das gerenderte HTML analysieren.

Ziel: Existiert ein Link zur Produktseite im Main Content?

Unsere Aufgabe lautete: Prüfen, ob auf einer Seite ein Link zur passenden Produktseite vorhanden ist – und zwar im Main Content. Navigation, Footer & Co. bleiben dabei außen vor.

Dazu haben wir folgenden XPath-Ausdruck verwendet:

boolean(//div[@data-testid="markdown"]//a[@href='[<https://dummydomain.com/>](<https://aiven.io/postgresql>)produkt1'] | //div[@data-testid="markdown"]//a[@href='/produkt1'])

Warum nur der Main Content zählt

Der sogenannte Main Content ist der inhaltliche Kernbereich einer Seite – also der Abschnitt, in dem Texte, Bilder, Videos & Co. erscheinen, jedoch ohne wiederkehrende Elemente wie Header oder Footer. Er ist meist klar abgegrenzt (z. B. durch ein <main>-Tag oder einen speziellen Container wie hier data-testid="markdown").

Warum das wichtig ist:

- Suchmaschinen werten Links im Main Content als besonders relevant – sie gelten als kontextbezogen und nützlich.

- Links in Header oder Footer enthalten oft die Kernprodukte, weshalb diese Bereiche ausgeschlossen werden müssen, um sinnvolle URL-Ergebnisse zu erhalten.

So konnten wir gezielt URL-Listen erstellen, auf denen zwar ein Produkt genannt, aber nicht verlinkt wurde – und genau dort gezielt interne Verlinkungen ergänzen, wo sie wirklich den Unterschied machen.

(Eine gute Übung um XPath Kenntnisse aufzufrischen!)

XPath-Funktionen erklärt

Werfen wir einen genaueren Blick auf die genutzten XPath-Funktionen.

-

//div[@data-testid="markdown"]Wählt alle

<div>-Elemente mit dem Attributdata-testid="markdown"aus – egal, wo sie im Dokument vorkommen.→ Dieser Container grenzt den Content-Bereich ein. Somit haben wir sichergestellt, dass Header und Footer-Element wie Navigation ausgeschlossen werden. Das unterscheidet sich aber von Website zu Website, je nach HTML-Struktur.

-

//a[@href='<https://dummydomain.com/produkt1>']Wählt

<a>-Elemente mit dem genauenhref-Attributhttps://dummydomain.com/produkt1, die innerhalb des obigen<div>-Elements vorkommen.→ Hier suchen wir nach der kompletten URL im Content-Bereich (

<div>). -

//a[@href='/produkt1']Ebenso wie oben, aber sucht nach einem relativen Link

/produkt1.→ Hier suchen wir auch nach einem relativen Link des Produkts.

-

|(Union-Operator)Dieser Operator bedeutet: "oder" – es wird geprüft, ob mindestens eines der beiden

<a>-Elemente existiert. -

boolean(...)Wandelt das Ergebnis (eine Node-Set) in einen Booleschen Wert um.

- Gibt

truezurück, wenn mindestens ein passendes Element gefunden wurde. - Gibt

falsezurück, wenn kein passendes Element existiert.

- Gibt

Am Ende lässt sich einfach nach false filtern – und voilà: wir bekommen eine Liste aller Seiten ohne Verlinkung.

Die URLs haben wir in Google Sheets exportiert und pro Produkt aufbereitet. Das Beispiel unten zeigt Seiten, die das Produkt “Kafka” erwähnen – aber (noch) kein Link zur Produktseite vorhanden ist:

👉 Beispiel-Liste in Google Sheets für ein Produkt

Diese Liste war unsere Grundlage, um gezielt interne Verlinkungen zu setzen – genau da, wo sie gebraucht werden.

Fazit: Eine smarte Methode für mehr Sichtbarkeit

Mit wenig Aufwand konnten wir gezielt Linklücken im bestehenden Content identifizieren – und systematisch schließen. Das Resultat: Mehr interne Signale für unsere Produktseiten, besseres Crawling und eine gestärkte interne Linkstruktur.

Tool Stack:

- Screaming Frog SEO Spider (Custom Extraction mit XPath)

- Google Sheets (Dokumentation & Abstimmung mit Redaktion)

- Ahrefs (optional für ergänzende Filter)

Noch ein Tipp zum Schluss: XPath ist eine super Möglichkeit, das Maximum aus deinen Crawls herauszuholen – und nebenbei deine technischen SEO-Skills auf das nächste Level zu bringen. Hier geht’s zur XPath-Einführung.

P.S.: Wenn du Fragen zum Thema hast oder deiner digitalen Präsenz einen kräftigen Boost geben möchtest, schreib uns via Kontaktformular oder auf LinkedIn. Wir freuen uns auf dich!

Das könnte dich auch interessieren:

- Content-Redaktionsplan erstellen

- Was sind SEO-relevante Meta-Elemente?

- CAMPIXX 2024 (mit Google Sheets Hacks PDF)

- CAMPIXX 2025

- Effektiver Content OnPage Audit (Template)

- Content-Konsolidierung

- Programmatic SEO – Content auf Autopilot

- Content Performance Audit (Template)

- Custom GPTs für besseres Copywriting (gratis Prompts)

- Barrierefreiheit von Websites (mit gratis Checkliste)

- SEO-Check in Minuten (gratis Template)