TL;DR

- Strukturierte Daten sind für LLMs relevant und stellen einen entscheidenden Wettbewerbsvorteil in der Ära der generativen KI dar.

- LLMs greifen auf Schema-Daten zu; sowohl passiv im Pre-Training (Lernen von Weltwissen und Ontologien) als auch aktiv in der Inferenz (RAG, Live-Browsing).

- Unternehmen müssen umdenken. Es reicht nicht mehr, Inhalte für Menschen zu optimieren. Webseiten müssen zu semantischen Datenbanken werden, die ihre Informationen über Schema.org so explizit wie möglich an KI-Systeme kommunizieren.

Strukturierte Daten sind in der traditionellen Suchmaschinenoptimierung unerlässlich, denn sie ermöglichen Google & Co., Inhalte besser zu verstehen und visuell ansprechend darzustellen (etwa in Form von Rich Snippets). Grundlage dafür ist meist ein vordefiniertes Vokabular wie Schema.org, das Informationen für Maschinen zugänglich macht.

Doch was bedeutet das im Zeitalter von Large Language Models (LLMs)? Wenn KI ohnehin die natürliche Sprache versteht, scheint die Notwendigkeit semantischer Auszeichnung fraglich. Tatsächlich aber gewinnen strukturierte Daten durch LLMs an neuer Relevanz: Sie helfen dabei, Informationen kontextgenau und verlässlich zu interpretieren und legen so die Basis für Sichtbarkeit in KI-getriebenen Anwendungen.

Welchen Einfluss haben strukturierte Daten auf LLMs?

Um die Relevanz strukturierter Daten wirklich einschätzen zu können, ist es wichtig, die zwei Hauptphasen eines Large Language Models (LLM) zu unterscheiden: das Pre-Training, bei dem das Modell allgemeines Weltwissen erlernt, und die Inferenz, in der es auf neue Anfragen reagiert und kontextuelle Informationen verarbeitet.

Die sogenannten Basismodelle (Foundation Models) aktueller KI-Systeme beziehen ihr Weltwissen überwiegend aus öffentlich zugänglichen Webarchiven. Eine zentrale Rolle spielt dabei der Common Crawl – ein riesiges Korpus, der mehrere Petabytes an Webdaten umfasst. Diese Daten liegen sowohl als unstrukturierter Text (z. B. im HTML-Body) als auch in strukturierten Formaten wie JSON-LD oder Microdata vor.

Die Qualität der Trainingsdaten hat direkten Einfluss auf die Leistungsfähigkeit eines LLMs. Moderne Trainings-Pipelines nutzen dafür komplexe heuristische Filter, um toxische, irrelevante oder qualitativ minderwertige Inhalte auszusortieren. Strukturierte Daten können in diesem Prozess als zusätzliches Qualitätssignal wirken. Sie erhöhen damit nicht automatisch die Aufnahme in ein Trainingsset, können aber zur besseren Einordnung und Bewertung von Inhalten beitragen.

Warum sind strukturierte Daten wichtig?

Es gibt viele gute Gründe, weshalb strukturierte Daten für LLMs wichtig sind.

- Vermittlung von Sorgfalt und Vertrauen: Strukturierte Daten signalisieren technische Sorgfalt und inhaltliche Vertrauenswürdigkeit. Sie allein führen zwar nicht automatisch zu besseren Rankings oder einer bevorzugten Verarbeitung durch LLMs, dennoch können sie im Pre-Training als positives Qualitätssignal wirken. Gerade in Kombination mit einer sauberen Informationsarchitektur ermöglichen sie es Crawlern und Modellen, Inhalte effizienter einzuordnen und zu validieren.

- Semantische Klarheit: LLMs verarbeiten Text in Form von Tokens. Vergleichende Analysen der Tokenisierungseffizienz zeigen, dass JSON-Formate aufgrund ihrer syntaktischen Redundanz (Klammern, Anführungszeichen) oft mehr Tokens verbrauchen als äquivalente Markdown-Repräsentationen. Markdown ist token-effizienter und wird von Modellen oft als „natürlicher“ empfunden, da es näher an der menschlichen Textstruktur liegt. JSON hingegen bietet explizite Typisierung und hierarchische Klarheit. Die Forschung deutet jedoch darauf hin, dass die Token-Effizienz weniger kritisch ist als die semantische Eindeutigkeit.

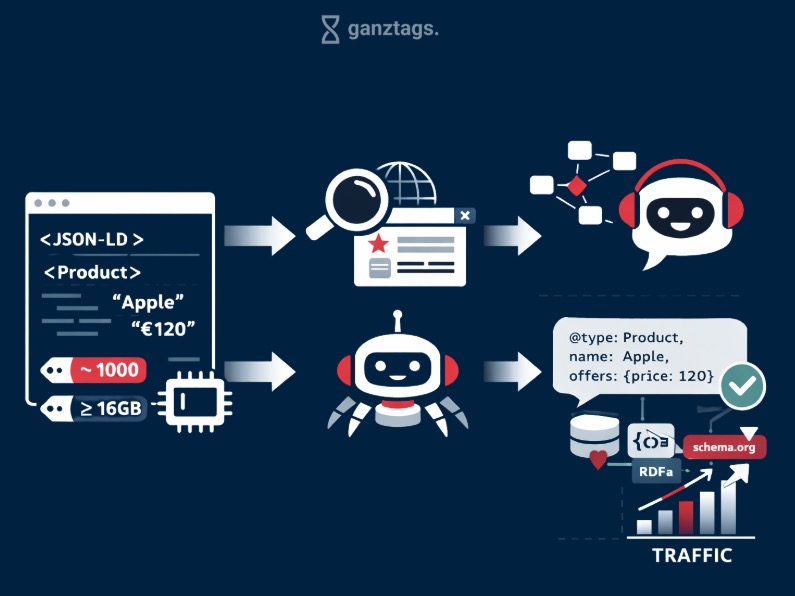

Beispiel: Ein Textfragment wie „Apple, 120€“ könnte sich auf eine Aktie oder eine Obstkiste beziehen. Durch die Injektion von Schema.org-Markup (z. B. @type: Product, name: Apple, offers: {price: 120}) werden Ambiguitäten eliminiert.

Untersuchungen zeigen, dass klar strukturierte Ein- und Ausgaben die Verlässlichkeit von automatischen Agentensystemen deutlich verbessern. Das Konzept PARSE (Prompts for Autonomous Robust Structured Extraction) zeigt, dass es besonders hilfreich ist, das Datenformat und die Art der Informationsgewinnung gemeinsam zu optimieren. Dadurch kann die Genauigkeit beim Herausfiltern von Informationen im Vergleich zu bisherigen führenden Verfahren um bis zu 64,7 % gesteigert werden. Dies macht deutlich, dass eine klare Datenstruktur nicht nur unterstützend wirkt, sondern die Leistungsfähigkeit des Modells aktiv erhöht.

Die beobachteten Genauigkeitsgewinne entstehen nicht durch die bloße Existenz strukturierter Daten, sondern durch Systeme, die gezielt darauf ausgelegt sind, diese Strukturen korrekt auszulesen und zu verarbeiten.

- Höhere Genauigkeiten durch Pre-Filtering: Wenn die zugrunde liegenden Daten strukturierte Metadaten enthalten (extrahiert aus Schema.org), kann das System „Pre-Filtering“ anwenden. Die Abfrage wird hybrid ausgeführt: Ein harter Filter auf “price < 1000” und “memorySize >= 16GB” wird mit einer Vektorsuche nach dem Kontext kombiniert. Dies erhöht die Präzision der Ergebnisse drastisch und verhindert, dass irrelevante Informationen in den Kontext des LLMs gelangen. Allerdings passiert das nicht automatisch. Das Retrieval-System muss so gebaut sein, dass es strukturierte Metadaten als Filter interpretiert – ein bewusster architektonischer Schritt, für den EntwicklerInnen verantwortlich sind.

- Reduktion von Halluzination: Besonders in sensitiven Bereichen (YMYL – Your Money or Your Life) ist die Reduktion von Halluzinationen kritisch. Benchmarks zeigen, dass die Injektion von strukturiertem Kontext (z. B. FHIR-Ressourcen im Gesundheitswesen oder Schema.org-Markup für juristische Entitäten) die faktische Konsistenz ("Factual Consistency") der Antworten verbessert. Vektordatenbanken allein reichen hier oft nicht aus; Knowledge Graphs, die durch strukturierte Daten gespeist werden, bieten die notwendige "Grounding"-Ebene, um Halluzinationen durch Faktenprüfung ("Fact Checking") abzufangen.

Tipp: Erfahre mehr über Grounding und weitere wichtige Konzepte wie RAG in unserem Post So machst du deine Website technisch fit für LLMs.

Wann wird der Einsatz strukturierter Daten problematisch?

Ein Problem beim Einsatz strukturierter Daten entsteht, wenn sie nicht mit dem sichtbaren Text einer Webseite übereinstimmen. Solche Inkonsistenzen (etwa abweichende Preise im Fließtext und im JSON-LD) werden von Google gemäß den Spam-Richtlinien als sogenanntes „Cloaking“ bewertet und entsprechend abgestraft. Auch für LLMs wirkt sich diese Diskrepanz negativ aus, da sie die Vertrauenswürdigkeit der Quelle untergräbt.

Deshalb ist es essenziell, dass HTML-Body und JSON-LD inhaltlich synchronisiert sind, um als verlässliche Informationsquelle für KI-Systeme zu gelten. Finden moderne LLMs widersprüchliche Angaben, tendieren sie in der Regel dazu, den strukturierten Daten mehr Gewicht zu geben – vorausgesetzt, das Schema ist technisch valide. Dies liegt daran, dass strukturierte Daten oft aus Datenbanken generiert werden (System of Record), während Text oft manuell und fehleranfällig ist. Google warnt jedoch davor, dass massive Diskrepanzen zu manuellen Abstrafungen führen können, da die Nutzererfahrung beeinträchtigt wird.

Was ist der Unterschied zwischen Vektor-RAG & Graph-RAG?

Eine Evolution des RAG-Ansatzes ist „GraphRAG“, bei dem Informationen in Wissensgraphen organisiert werden. Hierbei sind strukturierte Daten unverzichtbar.

| Merkmal | Vektor-RAG (Unstrukturiert/HTML) | Graph-RAG (Strukturiert/Schema) | Implikation für LLM-Performance |

|---|---|---|---|

| Datenstruktur | Flache Liste von Text-Chunks | Netzwerk aus Knoten (Entitäten) und Kanten (Beziehungen) | GraphRAG ermöglicht komplexes Reasoning |

| Abfragelogik | Semantische Ähnlichkeit („Ähnelt X“) | Relationale Logik („Ist Teil von Y“, „Verursacht Z“) | Schema-Daten liefern die expliziten Kanten für den Graphen |

| Kontextverständnis | Begrenzt auf das Chunk-Fenster | Globales Verständnis über Dokumentgrenzen hinweg | Reduktion von „Lost in the Middle“-Phänomenen |

| Erklärbarkeit | Gering (Black Box Embeddings) | Hoch (Nachverfolgbare Pfade im Graphen) | Kritisch für Enterprise-Anwendungen und Compliance |

| Datenquelle | Quelle 1 | Quelle 2 | Strukturierte Daten sind die Basis für Graph-Konstruktion |

Die Analyse zeigt, dass GraphRAG-Systeme, die auf strukturierten Daten basieren, besonders bei komplexen „Multi-Hop“-Fragen überlegen sind (z. B. „Welche Nebenwirkungen haben Medikamente, die von Firma X hergestellt werden?“). Reine Vektor-Systeme scheitern hier oft, da die Beziehung zwischen „Firma X“ und „Medikament Y“ im unstrukturierten Text weit verstreut sein kann. Schema.org liefert die Blaupause (manufacturer, drugClass), um diese Verbindungen explizit zu modellieren.

Unstrukturierter HTML-Code ist schwer, intelligent zu zerlegen. Ein Schnitt mitten in einer HTML-Tabelle kann den Zusammenhang zwischen Spaltenüberschrift und Zelleninhalt zerstören.

Strukturierte Daten (JSON-LD) sind von Natur aus objektorientiert und atomar. Sie bilden logische Einheiten, die als Ganzes „gechunkt“ werden können. Ob diese Einheiten beim Retrieval vollständig im Kontext des LLMs landen, hängt jedoch vom Chunker ab – also der Logik, die entscheidet, wie Inhalte aufgeteilt und ins Modell eingespeist werden. Nur wenn der Chunker entsprechend konfiguriert ist, bleibt das Objekt intakt. Die reine Präsenz strukturierter Daten garantiert das nicht.

Dies widerlegt die Annahme, dass LLMs „alles lesen können“ und strukturierte Daten überflüssig seien. Zwar können sie unstrukturierten Text lesen, aber die Zuverlässigkeit (Reliability) der Extraktion ist bei strukturierten Quellen exponentiell höher.

Strukturierte Daten & Sichtbarkeit – Case Studies

Strukturierte Daten erhöhen vermutlich die Wahrscheinlichkeit einer Zitierung ("Citation Readiness"). KI-Modelle suchen nämlich nach effizienten Wegen, Informationen zu verifizieren, und bevorzugen deshalb Quellen, die Daten maschinenlesbar bereitstellen.

Hier sind Beispiele aus einigen Case Studies, die zeigen, wie sich strukturierte Daten auf die Sichtbarkeit auswirken.

E-Commerce: Produkte mit Schema erschienen in KI-Empfehlungen 3-5x häufiger als solche ohne.

Informational: In einer umfangreichen Studie untersuchte Salt.agency mehr als 100.000 Webseiten im „AI Mode“. Das Ergebnis: Standard-Schemata (Organization, Article) sind zwar weit verbreitet sind, aber die reine Präsenz von Markup garantiert nicht automatisch Rankings. Erst wenn strukturierte Daten konsequent gepflegt, semantisch präzise und für KI-Systeme aktiv nutzbar sind, tragen sie zur Sichtbarkeit bei. Entscheidend ist also nicht das Ob, sondern das Wie der Implementierung.

Traffic-Boost: Eine gezielte Optimierung für AI Overviews – inklusive Google Business Profile und Schema – führte laut einer Case Study von Diggity Marketing zu einem Anstieg des AI-Referral-Traffics um 370 %.

Wichtig: Jedes LLM verarbeitet Daten unterschiedlich, d. h. auch der Effekt auf die Sichtbarkeit wird nicht für jedes Modell gleich ausfallen. Hinzu kommt, dass die Modelle einem ständigen Wandel unterstehen.

Fazit: Strukturierte Daten sind ein strategisches Asset

LLMs verändern, wie Inhalte gefunden, verstanden und wiedergegeben werden. Strukturierte Daten sind dabei kein optionales Extra, sondern ein entscheidender Faktor für Sichtbarkeit, Vertrauen und Relevanz. Wer frühzeitig in semantische Architektur investiert, verschafft sich einen klaren Vorteil; sowohl in der klassischen Suche als auch in KI-getriebenen Interfaces.

Du brauchst Unterstützung bei der Implementierung? In unserem Audit für strukturierte Daten analysieren wir deine Website technisch sowie inhaltlich und zeigen dir, wie du deine Inhalte zukunftssicher strukturierst und auch im KI-Zeitalter sichtbar bleibst. Melde dich einfach über unsere Website oder schreibe uns auf LinkedIn. Wir freuen uns auf dich!

Das hier könnte dich ebenfalls interessieren:

Blog

Produktseite erstellen & optimieren (Checkliste)

Effektiver Content OnPage Audit (Tutorial & Google Sheets Template)

Barrierefreiheit von Websites (Checkliste)

Leistungen