TL;DR

- Saubere XML-Sitemaps sind für KI-Systeme wichtig, denn sie bilden eine Quelle, die LLMs für URL-Entdeckung und Ermittlung von Relevanz einbeziehen.

- Das

<lastmod>-Tag bleibt ein wichtiges Signal in XML-Sitemaps, das KI-Suchsystemen hilft, aktualisierte Inhalte priorisiert zu crawlen. - Wer heute in KI-Antworten sichtbar sein will, muss technische SEO auch aus Sicht von LLMs denken. Sitemaps sind dabei der Startpunkt.

- Unsere Empfehlung: Halte deine Sitemaps aktuell, reduziere sie auf erreichbare und indexierbare URLs, pflege

<lastmod>konsequent, segmentiere Inhalte semantisch, nutze separate Bild-Sitemaps und prüfe optional den Einsatz einer llms.txt im Markdown-Format.

In der klassischen Suchmaschinenoptimierung sind gut gepflegte und genaue Sitemaps sehr wertvoll – sie bilden nämlich das Fundament für ein strukturiertes Index Management und helfen dabei, auch tiefer liegende Inhalte effizient auffindbar zu machen.

Doch mit dem Aufkommen von Large Language Models (LLMs) stellt sich eine neue Frage: Müssen wir unsere Sitemap-Strategie überdenken? Und brauchen KI-Systeme vielleicht sogar eine eigene, speziell optimierte Sitemap?

Die Divergenz der Crawling-Ziele

Traditionelle Suchmaschinen wie Google operieren mit dem Ziel der Indexierung als notwendigem Schritt für das Ranking. Der Crawler (z. B. Googlebot) besucht eine Seite, rendert den Inhalt (inklusive JavaScript), extrahiert Links und speichert Signale für das spätere Retrieval. Die Sitemap dient hier der Vollständigkeit (Coverage), um sicherzustellen, dass auch tief verschachtelte oder verwaiste Seiten (Orphan Pages) entdeckt werden.

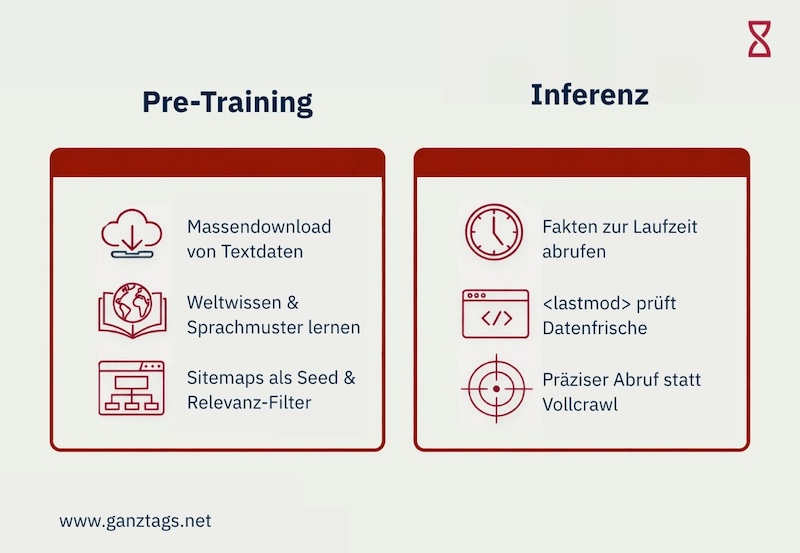

Im Gegensatz dazu operieren LLMs und KI-Agenten in zwei distinkten Phasen, die unterschiedliche Anforderungen an Sitemaps stellen:

- Pre-Training (Ingestierung): Hierbei geht es um den massenhaften Download von Textdaten, um das "Weltwissen" und die Sprachmuster des Modells zu trainieren. Crawler wie der CCBot (Common Crawl) oder GPTBot zielen auf eine Maximierung des Textdurchsatzes bei Minimierung der Rechenkosten ab. JavaScript wird oft ignoriert, um Ressourcen zu sparen. Die Sitemap fungiert hier als Filter für Relevanz und als Seed-Liste für Bulk-Downloads.

- Inferenz (Grounding / RAG): Systeme wie Bing Chat, SearchGPT und Perplexity verwenden Techniken wie Retrieval-Augmented Generation (RAG), um Fakten während der Laufzeit zu suchen und einzubinden und so ihr vortrainiertes Wissen mit aktuellen Informationen zu ergänzen. Hier ist die Sitemap, insbesondere das

<lastmod>-Attribut, kritisch für die Bestimmung der Datenfrische (Freshness). Das Ziel ist nicht der Download des gesamten Webs, sondern der präzise Abruf der aktuellsten Information.

Die ökonomische Logik diktiert das Verhalten dieser Bots: Während Googlebot massive Ressourcen aufwendet, um komplexe Client-Side-Renderings zu verstehen, optimieren KI-Crawler wie GPTBot auf "Token pro Watt". Seiten, die ihre Inhalte nicht effizient über saubere Sitemaps und Server-Side-Rendering bereitstellen, werden in der Kosten-Nutzen-Rechnung der Crawler depriorisiert.

Die Sitemap als autoritäre Seed-Liste für LLMs

Ein Crawler beginnt seine Arbeit niemals in einem Vakuum. Er benötigt Startpunkte, sogenannte Seed-URLs. In der Vergangenheit wurden diese Seeds oft aus Listen populärer Domains generiert. Für eine tiefe Erschließung des Webs ist dies jedoch unzureichend.

Untersuchungen zeigen, dass Crawler wie der CCBot (die Basis für viele LLM-Datensätze) das Sitemap-Protokoll vollständig unterstützen und aktiv nutzen.

Wenn eine Domain in ihrer robots.txt auf eine Sitemap verweist, wird diese als priorisierte Liste von Crawl-Kandidaten behandelt. Dies ist wesentlich effizienter als das rekursive Verfolgen von internen Links ("Random Walk"), da es das Risiko minimiert, in Endlosschleifen (Spider Traps) oder Kalender-Generatoren zu geraten, die wertloses Datenvolumen erzeugen.

Die folgende Tabelle verdeutlicht die unterschiedlichen Crawling-Paradigmen und die Rolle der Sitemap darin:

| Merkmal | Klassischer Search Crawler (Googlebot) | KI Training Crawler (GPTBot, CCBot) | RAG / Inference Crawler (BingBot, Perplexity) |

|---|---|---|---|

| Primäres Ziel | Indexierung & Ranking-Berechnung | Massen-Datenakquise für Modellgewichte | Echtzeit-Faktenabruf & Quellen-Attribution |

| Rolle der Sitemap | Discovery & Canonical-Validierung | Seed-Liste für Bulk-Ingestion & Qualitätsfilter | Signal für Aktualität (<lastmod>) & Entitäten-Erkennung |

| Fehler-Toleranz | Hoch (Soft 404s werden ignoriert) | Niedrig (Fehler verschwenden Trainings-Ressourcen) | Extrem Niedrig (Veraltete Daten führen zu Halluzinationen) |

| JS-Handling | Vollständiges Rendering, aber nur sporadisch oder verzögert | Oft nur statisches HTML (Ressourceneffizienz) | Variabel, Präferenz für strukturierten Text / JSON-LD |

| Re-Crawl Frequenz | Basierend auf Popularität & PageRank | Unregelmäßig (oft Monate zwischen Snapshots) | Trigger-basiert durch Sitemap-Updates |

Aus dieser Gegenüberstellung wird deutlich, dass die Sitemap für KI-Systeme eine noch kritischere Rolle einnimmt als für klassische Suchmaschinen. Während Googlebot hochentwickelte Heuristiken besitzt, um auch ohne eine perfekte Sitemap zu funktionieren, verlassen sich die oft "dümmeren" (auf Effizienz getrimmten) Bulk-Crawler stärker auf explizite Anweisungen durch Sitemaps.

Zwischenfazit: Wenn Inhalte einer Webseite nicht im Common Crawl landen, ist die Wahrscheinlichkeit hoch, dass sie auch nicht Teil des Trainingsdatensatzes von Modellen wie Llama oder Falcon werden. Das bedeutet, dass das Modell kein "Wissen" über die spezifischen Fakten, Produkte oder Texte dieser Seite entwickelt. Eine saubere Sitemap ist somit die Eintrittskarte in das Langzeitgedächtnis der KI.

Datensatz-Kuratierung: RefinedWeb

Moderne KI-Entwicklung hat sich von "mehr Daten" zu "besseren Daten" verschoben. Datensätze wie RefinedWeb (genutzt für das Falcon-Modell) wenden aggressive Filter an, um Spam, Duplikate und minderwertigen Content zu entfernen.

Hierbei entsteht ein indirekter, aber mächtiger Zusammenhang zur Sitemap-Qualität:

Deduplizierung: Datensätze entfernen strikt Duplikate. Sitemaps helfen dabei, die kanonische Version einer URL zu definieren. Fehlt die Sitemap oder ist sie fehlerhaft, könnte der Crawler eine Parameter-URL (z. B. ?session_id=xyz) als Hauptversion crawlen. Diese wird später aufgrund von URL-Mustern oft ausgefiltert. Das Ergebnis: Der Inhalt fehlt im Trainingsset.

Domain Trust: Crawler bewerten die technische Hygiene einer Domain. Eine Sitemap mit hohen Fehlerraten (404, 5xx) signalisiert eine schlecht gewartete Seite. In Kuration-Pipelines wie der von RefinedWeb kann dies dazu führen, dass die gesamte Domain als "Low Quality" geflaggt und aus dem Datensatz entfernt wird.

→ Eine fehlerhafte Sitemap kann also aktiven Schaden anrichten.

Das <lastmod>-Attribut als kritische Infrastruktur

Lange wurde das <lastmod>-Tag (Datum der letzten Änderung) in XML-Sitemaps von Google weitgehend ignoriert, da Webmaster es oft missbrauchten (z. B. automatisches Setzen des aktuellen Datums auf allen Seiten). Mit dem Aufstieg von Bing Chat (Copilot) und anderen KI-Suchsystemen hat sich dieses Paradigma gewandelt.

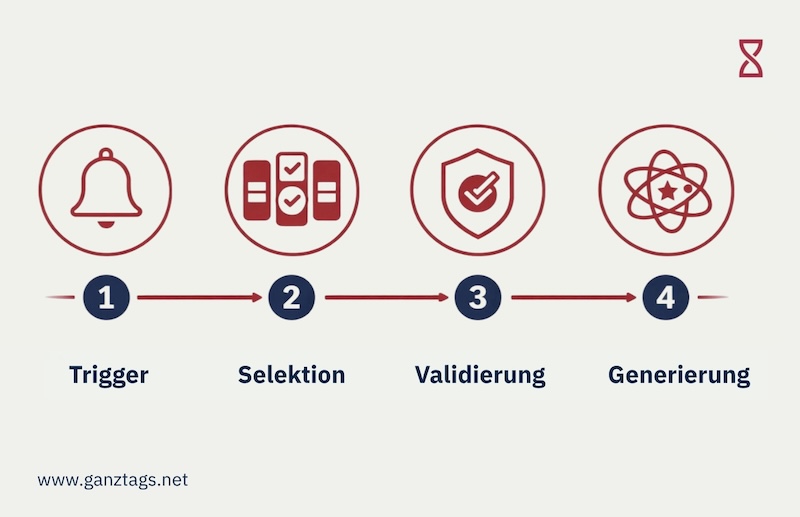

Der Mechanismus:

1. Trigger: NutzerInnen stellen eine Frage zu einem aktuellen Ereignis (z. B. "Wahlergebnisse heute").

2. Selektion: Das System identifiziert relevante Domains.

3. Validierung: Der Crawler prüft die Sitemaps dieser Domains. Findet er ein <lastmod>-Tag, das sehr aktuell (und im korrekten ISO 8601 Format) ist, wird diese URL priorisiert gecrawlt und in den Kontext des LLMs injiziert.

4. Generierung: Die KI nutzt den frischen Inhalt, um die Antwort zu generieren.

Fehlt das Tag oder ist es ungenau, verlässt sich das System auf historische Crawl-Daten. Dies führt dazu, dass die Seite bei aktuellen Anfragen ignoriert wird, da das Risiko einer "veralteten Halluzination" zu hoch ist.

KI Chatbots & Discovery ohne Search Console

KI Chatbots wie Perplexity AI gehören zu einer neuen Generation von Answer Engines. Im Gegensatz zu Google bietet Perplexity (Stand November 2025) keine umfassende "Webmaster Console" an, über die URLs manuell eingereicht werden können.

Dies erhöht die Abhängigkeit von passiven Discovery-Mechanismen. Perplexity nutzt Sitemaps, die in der robots.txt referenziert sind, nämlich als primäre Quelle für die Entdeckung neuer Inhalte. Darüber hinaus deutet die Architektur von Perplexity auf ein "Entity Search Reranking" hin. Das bedeutet, die Sitemap wird auch semantisch interpretiert und ist somit nicht nur für das Auffinden, sondern auch für das Verstehen von Seitenstrukturen relevant.

Eine logisch aufgebaute Sitemap – etwa mit klaren Pfaden wie /products/, /news/ oder /blog/ – hilft dem System dabei, Inhalte korrekt einzuordnen und gezielt bestimmten Entitäten zuzuweisen. Fehlt diese Struktur, ist Perplexity auf externe Links angewiesen, was die Indexierung deutlich verzögert.

Hinzu kommt: KI-Bots wie GPTBot arbeiten mit deutlich engeren Ressourcenbudgets als etwa der Googlebot. Ist das Fehlerbudget einer Domain erschöpft, wird der Crawlprozess abgebrochen – oft, bevor die hochwertigen Inhalte überhaupt erreicht werden.

LLM.TXT: Technische Spezifikation & Zielsetzung

Die llms.txt folgt einer anderen Philosophie als die XML-Sitemap. Während XML für Maschinen-Lesbarkeit (Parsing) optimiert ist, zielt llms.txt auf semantisches Verständnis. Es handelt sich um eine Markdown-Datei, die im Root-Verzeichnis einer Domain liegt (/llms.txt).

Der Aufbau ist standardisiert, aber flexibel:

- H1 Header: Name des Projekts/der Seite.

- Blockquote: Eine prägnante Zusammenfassung, worum es auf der Seite geht (Kontext für das LLM).

- Kuratierte Link-Listen: Im Gegensatz zur Sitemap, die alle URLs enthält, soll llms.txt nur die wichtigsten Quellen enthalten, die ein KI-Agent nutzen sollte, um Fragen zu beantworten (z.B. Dokumentation, API-Referenz, "Über uns").

Das Format nutzt Markdown, weil LLMs darauf trainiert sind, Markdown-Strukturen extrem effizient zu interpretieren. Es dient quasi als "Inhaltsverzeichnis für Agenten".

Adoption & Koexistenz

Aktuell befindet sich llms.txt noch in der Adoptionsphase. Anthropic hat zum Beispiel begonnen, den Standard für seine eigene Dokumentation zu nutzen und empfiehlt ihn implizit für EntwicklerInnen. Auch Plattformen wie Cloudflare und Mintlify unterstützen die Generierung.

Kritiker merken an, dass große Suchbots wie Googlebot die Datei noch nicht offiziell als Ranking-Signal nutzen. Dies verkennt jedoch den Zweck: llms.txt ist nicht primär für SEO (Search Engine Optimization) gedacht, sondern für AIO (Artificial Intelligence Optimization) und Agenten-Navigation.

| Feature | XML-Sitemap (sitemap.xml) | LLM-Manifest (llms.txt) |

|---|---|---|

| Format | XML (Starr, Metadaten-fokussiert) | Markdown (Semantisch, Kontext-fokussiert) |

| Inhalt | Vollständiges Inventar aller URLs | Kuratierte Auswahl ("Best of") & Erklärungen |

| Zielgruppe | Crawler (Googlebot, Bingbot) | LLMs (Inference), Agenten, RAG-Systeme |

| Discovery | Via robots.txt (automatisch) | Via robots.txt oder direkte Abfrage (experimentell) |

| Hauptnutzen | Indexierung & Freshness | Kontext-Steuerung & Token-Effizienz |

XML-Sitemaps & LLMs – ganztags. Take

Bei der ganztags. haben bisher noch keine llm.txt implementiert, da wir noch keinen echten Nutzen gegenüber XML-Sitemaps sehen und wie oben beschrieben, können schlecht gepflegte Sitemaps eher schaden. Da konzentrieren wir uns vorerst lieber auf eine Sitemap und monitoren und updaten diese engmaschig. Natürlich behalten wir das Thema weiter im Blick, um keine wichtigen Updates zu verpassen.

Fazit: Sitemap-Hygiene ist kein Nice-to-have, sondern die Grundlage für Sichtbarkeit in KI-Systemen

Saubere Sitemaps sind mehr als nur eine SEO-Maßnahme, sie sind dein direkter Kommunikationskanal zu KI-Systemen. Wenn du möchtest, dass deine Inhalte in Trainingsdaten, Antwortsystemen und KI-Agenten auftauchen, solltest du diese fünf Punkte im Blick behalten:

- Hygiene ist Priorität: Überprüfe und aktualisiere deine Sitemap regelmäßig. Stelle sicher, dass nur erreichbare, indexierbare URLs enthalten sind. Entferne alle, die keinen Status 200 liefern. Jede 404 oder Weiterleitung ist ein Signal für "Low Quality" an KI-Crawler.

- Pflege das

<lastmod>-Feld konsequent: Gib das tatsächliche Änderungsdatum an und achte auf das korrekte Format. - Segmentiere deine Sitemap semantisch: Zum Beispiel nach Inhaltstypen wie /produkte/, /blog/ oder /news/.

- Aktive Steuerung via robots.txt: Referenziere Sitemaps explizit. Überlege genau, welche Bots (GPTBot, CCBot) du zulassen willst, aber sei dir bewusst, dass Blockieren auch "Unsichtbarkeit" im Modell bedeutet.

- Lege eine separate Sitemap für Bilder an: So können Medieninhalte gezielt gecrawlt werden.

- Setze frühzeitig auf llms.txt: Bereite dich auf die Zukunft vor, indem du eine kuratierte Markdown-Datei bereitstellst. Dies positioniert deine Inhalte optimal für die nächste Generation von KI-Agenten.

- Technische Barrierefreiheit: Stelle sicher, dass die in der Sitemap verlinkten Seiten auch für Bots ohne JavaScript-Ausführung lesbar sind (Server-Side Rendering), da viele KI-Crawler aus Kostengründen kein JS rendern.

In der Ökonomie der KI-Modelle ist saubere Datenstruktur die wertvollste Währung. Eine perfekte Sitemap ist der effizienteste Weg, diese Währung bereitzustellen.

Du brauchst Unterstützung bei der Implementierung sauberer XML-Sitemaps? Melde dich einfach über unsere Website oder schreibe uns auf LinkedIn. Wir freuen uns auf dich!

Sitemap & LLMs – Häufig gestellte Fragen (FAQ)

Wie verhindere ich, dass KI-Modelle veraltete Fakten über mein Unternehmen halluzinieren?

KI-Halluzinationen entstehen oft, weil das Modell auf veraltete Trainingsdaten zugreift. Durch ein präzises <lastmod>-Tag in deiner Sitemap zwingst du moderne RAG-Systeme (wie den Bing Copilot oder Perplexity), deine aktuellsten Informationen direkt in den Antwort-Kontext zu ziehen. Es ist dein effektivstes Werkzeug, um die „Wahrheit“ über dein Unternehmen in KI-Antworten aktiv zu steuern und sicherzustellen, dass Fakten, Preise oder Angebote immer auf dem neuesten Stand sind.

Müssen wir unsere bestehende Sitemap für LLMs anpassen oder reicht die aktuelle aus?

Nur wenn deine Sitemap aktuell, semantisch strukturiert und fehlerfrei ist, kann sie von LLMs effizient genutzt werden. Veraltete oder unstrukturierte Sitemaps führen zu Sichtbarkeitsverlust.

Was ist der Unterschied zwischen einer klassischen Sitemap und einer llms.txt? Brauche ich beides?

Eine klassische XML-Sitemap ist ein technisches Verzeichnis aller indexierbaren Seiten – sie wird von Suchmaschinen-Crawlern wie Googlebot oder Bingbot genutzt, um Inhalte zu erfassen und zu bewerten. Die llms.txt hingegen ist ein neuer, experimenteller Standard, der speziell für KI-Systeme wie Chatbots und Agenten entwickelt wurde. Sie ist semantisch kuratiert, nutzt das Markdown-Format und listet nur die wichtigsten Inhalte einer Website auf (etwa Produktseiten, Dokus oder erklärende Beiträge). Ob du beides brauchst, hängt von deiner Zielsetzung ab: Wenn du möchtest, dass KI-Agenten deine Inhalte gezielt für Antworten nutzen, kann eine llms.txt helfen, die Relevanz zu erhöhen. Sie ersetzt aber keine XML-Sitemap, sondern ergänzt sie strategisch.

Sollte ich alle meine URLs in die Sitemap aufnehmen?

Nicht jede Seite gehört in die Sitemap. Du solltest nur URLs eintragen, die technisch erreichbar, indexierbar und qualitativ relevant sind – also solche, die du aktiv im Google-Index und in KI-Systemen sehen möchtest. Weiterleitungen, 404-Seiten, Duplicate Content oder URLs mit Session-Parametern solltest du bewusst ausschließen.

Das hier könnte dich ebenfalls interessieren:

Blog

Wie relevant sind strukturierte Daten für LLMs wirklich?

Barrierefreiheit von Websites (Checkliste)

Leistungen